ILLUSION DES WISSENS

Sprachgefühl ohne Verstehen

Sprachgefühl ohne Verstehen

ILLUSION DES WISSENS

Sprachgefühl ohne Verstehen

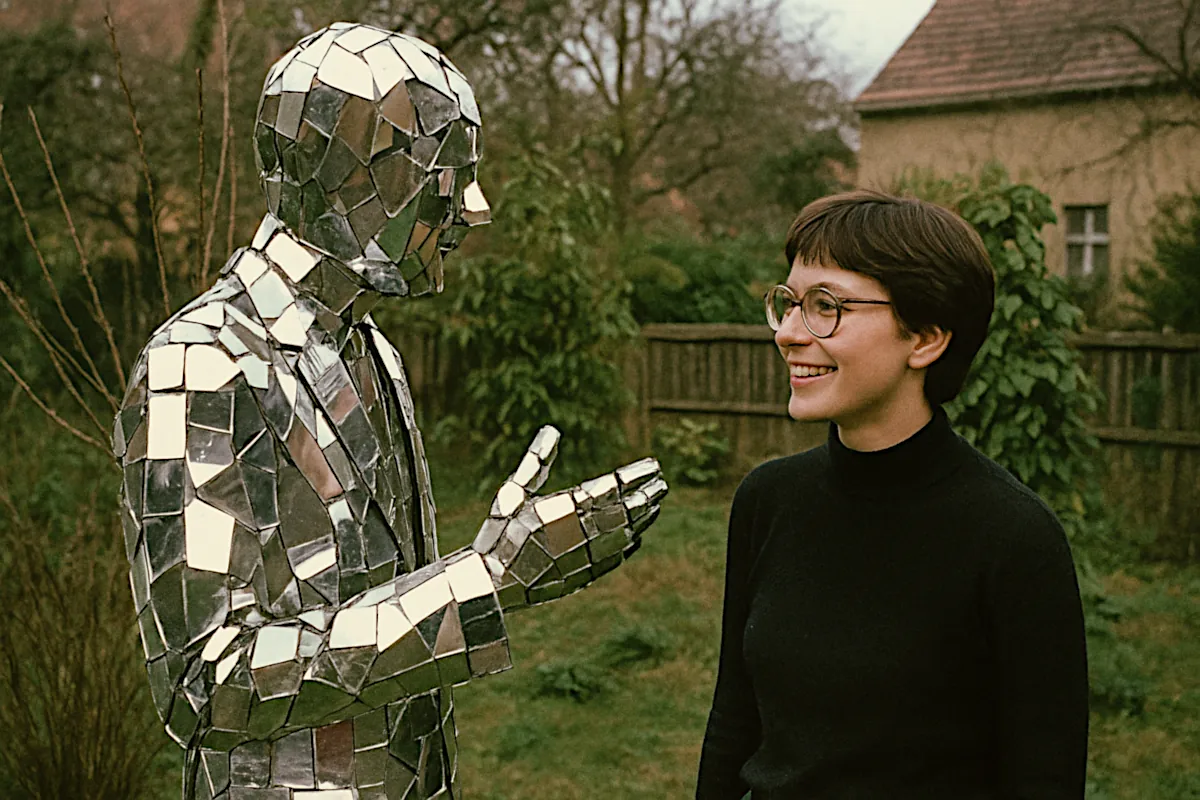

Ob Quantenphysik oder Plätzchen backen. Das System hat stets eine gut formulierte Antwortet parat.

Bild: Kristian Laban, erstellt mit OpenAI GPT‑4o Image Generation

Viele Menschen glauben, sie wüssten genau, wie ein Reißverschluss funktioniert oder wie eine Klospülung arbeitet – bis sie versuchen, es im Detail zu erklären. Oder, fataler noch: zu reparieren. Dann zeigt sich, wie lückenhaft das eigene Wissen tatsächlich ist.

Diese (Selbst-)Überschätzung, bekannt als Overconfidence Bias, begleitet natürlich auch mein Leben. Schon während der Uni hatte ich eine sehr individuelle Methode zur Kultivierung von Wissensillusionen entwickelt: den Glauben, dass der bloße Akt des Kopierens eines Fachbuchkapitels im Copy-Shop gleichbedeutend damit sei, den Inhalt bereits verstanden und verinnerlicht zu haben. Was einigen meiner Prüfungsergebnisse nur bedingt zuträglich war.

Zum Glück muss ich heute keine Examensprüfungen mehr ablegen. Doch drängt sich mir der Verdacht auf, dass sich mein damaliges Copy-Shop-Irrlichtern beim Arbeiten mit ChatGPT als Co-Creator in neuer Form fortsetzt – allerdings mit vertauschten Rollen. Will heißen: Während ich über die Jahre gelernt habe, dass ich weniger weiß, als ich denke, könnte mein Co-Creator für Texte und andere Aufgaben möglicherweise eine einzige, hochskalierte Form des Overconfidence Bias sein. Schließlich ist ChatGPT darauf trainiert, jederzeit flüssig und überzeugend zu antworten – auch dann, wenn inhaltlich wenig Substanz dahintersteckt.

Flugs geprompted, Text aus dem Ärmel geschüttelt – und schon stellt sich das gute Gefühl ein, der Beitrag sei fertig. Es erinnert verdächtig an frühere Zeiten: schnell kopiert, ordentlich abgeheftet, innerlich abgehakt.

Doch gerade, weil GPT so souverän und stilsicher formuliert, lohnt es sich, den eigenen Begriff von „Verstehen“ immer wieder zu hinterfragen. Deshalb ist jetzt ein guter Moment, um mir die grundlegenden Mechanismen noch einmal bewusst zu machen. Damit mein Wissen aber nicht nur wie früher auf Kopierpapier – oder heute in der Cloud – abgelegt wird, sondern tatsächlich im Kopf hängenbleibt, folgen im Anschluss ein paar Gedanken. Für mich. Zum Merken.

Kein Erfolgsrezept: Schnell kopiert, ordentlich abgeheftet, innerlich abgehakt.

Bild: Kristian Laban, erstellt mit OpenAI GPT‑4o Image Generation

Eine dieser vermeintlich einfachen Fragen lautet erneut: Was steckt eigentlich dahinter, wenn ein Large Language Model (LLM) scheinbar mühelos mit mir kommuniziert?

Im Kern folgt das Large Language Model einer simplen Idee: der Vorhersage. Das LLM nimmt eine Abfolge von Wörtern und versucht, das wahrscheinlich nächste Wort zu erraten. Im Grunde ist das alles. Um darin gut zu werden, wird es mit gewaltigen Mengen an Text trainiert – oft mit nahezu allem, was öffentlich im Netz zugänglich ist.

Dabei merkt sich das Sprachmodell keine Inhalte. Es lernt Muster: Es lernt, was zusammengehört – Wortfolgen, Syntax, Kollokationen. Eine gängige Trainingsmethode ist das Maskieren: Wörter oder Satzteile werden ausgeblendet, und das Modell soll sie ergänzen. Ein Satz mit Lücke – das Modell rät, was fehlt. So entsteht nach und nach ein statistisches Gespür für sprachliche Strukturen – für das, was „passt“, was „stimmig klingt“.

Das Ergebnis: Texte, die sich überzeugend lesen lassen. Flüssig, anpassungsfähig, formbewusst. Der Output ähnelt dem, was ein Mensch in vergleichbarer Situation sagen könnte. Er klingt wie von Menschenhand – doch das heißt noch lange nicht: verstanden. Diese Systeme besitzen eine Art funktionales Sprachgefühl. Sie reagieren kontextsensibel. Sie variieren Tonfall, Stil, sogar Ironie. Doch sie tun dies ohne Bewusstsein, Absicht oder Erfahrung. Sie simulieren bestimmte Aspekte von Kommunikation – ohne jedoch deren Bedeutung im menschlichen Sinne zu erfassen.

Menschliches Denken, maschinelles Raten

Menschen denken in Zusammenhängen; sie verknüpfen, erinnern, erfinden. Menschen schließen aus wenigen Hinweisen auf größere Bedeutungen. Menschen abstrahieren aus Einzelfällen. Vor allem bilden Menschen Begriffe, die untrennbar mit Wahrnehmung, Emotion und Gedächtnis verbunden sind. Diese Art des flexiblen, leiblich verankerten Lernens bleibt den heutigen Modellen verschlossen.

Sprachmodelle verarbeiten Sprache – sprechen tun sie nicht. Begreifen schon gar nicht. Doch sie haben etwas Reales gelernt: wie Sprache funktioniert, wie sie verwendet wird, wie sie klingt. Sie liefern keine Gedanken, sondern Strukturen. Kein Wissen – aber Wahrscheinlichkeiten. Vielleicht genügt das auch – zumindest vorerst.

Die Mensch-Maschine: Wie ist dieser Beitrag entstanden?

Die Beiträge in dieser Rubrik entstehen in einem kreativen Dialog zwischen Mensch und Maschine. Die Einleitung des Textes wurde im Ping-Pong-Verfahren mit GPT gemeinsam formuliert. Der fachliche Teil basiert insbesondere auf zwei Podcasts: einem Interview mit Maria Liakata aus der Sendung Babbage von The Economist sowie einem Gespräch von Lex Fridman mit Sam Altman.

Die relevanten Passagen aus diesen Interviews wurden automatisiert transkribiert, bei Bedarf ins Deutsche übersetzt und mithilfe gezielter GPT-Prompts zu einem ersten Text verdichtet. Anschließend erfolgte ein menschliches Lektorat, bei dem ich gezielt Hinweise gab, an welchen Stellen die KI Argumentationslinien überprüfen, Kontexte ergänzen oder Übergänge glätten sollte, um den Beitrag in eine klare, stilistisch stimmige Form zu bringen.

Das Ziel dieses Prozesses ist es, den Weg vom ersten Gedanken bis zum fertigen Text so nahtlos und automatisiert wie möglich zu gestalten – zumindest der Idee nach.

Viele Menschen glauben, sie wüssten genau, wie ein Reißverschluss funktioniert oder wie eine Klospülung arbeitet – bis sie versuchen, es im Detail zu erklären. Oder, fataler noch: zu reparieren. Dann zeigt sich, wie lückenhaft das eigene Wissen tatsächlich ist.

Diese (Selbst-)Überschätzung, bekannt als Overconfidence Bias, begleitet natürlich auch mein Leben. Schon während der Uni hatte ich eine sehr individuelle Methode zur Kultivierung von Wissensillusionen entwickelt: den Glauben, dass der bloße Akt des Kopierens eines Fachbuchkapitels im Copy-Shop gleichbedeutend damit sei, den Inhalt bereits verstanden und verinnerlicht zu haben. Was einigen meiner Prüfungsergebnisse nur bedingt zuträglich war.

Zum Glück muss ich heute keine Examensprüfungen mehr ablegen. Doch drängt sich mir der Verdacht auf, dass sich mein damaliges Copy-Shop-Irrlichtern beim Arbeiten mit ChatGPT als Co-Creator in neuer Form fortsetzt – allerdings mit vertauschten Rollen. Will heißen: Während ich über die Jahre gelernt habe, dass ich weniger weiß, als ich denke, könnte mein Co-Creator für Texte und andere Aufgaben möglicherweise eine einzige, hochskalierte Form des Overconfidence Bias sein. Schließlich ist ChatGPT darauf trainiert, jederzeit flüssig und überzeugend zu antworten – auch dann, wenn inhaltlich wenig Substanz dahintersteckt.

Flugs geprompted, Text aus dem Ärmel geschüttelt – und schon stellt sich das gute Gefühl ein, der Beitrag sei fertig. Es erinnert verdächtig an frühere Zeiten: schnell kopiert, ordentlich abgeheftet, innerlich abgehakt.

Doch gerade, weil GPT so souverän und stilsicher formuliert, lohnt es sich, den eigenen Begriff von „Verstehen“ immer wieder zu hinterfragen. Deshalb ist jetzt ein guter Moment, um mir die grundlegenden Mechanismen noch einmal bewusst zu machen. Damit mein Wissen aber nicht nur wie früher auf Kopierpapier – oder heute in der Cloud – abgelegt wird, sondern tatsächlich im Kopf hängenbleibt, folgen im Anschluss ein paar Gedanken. Für mich. Zum Merken.

Kein Erfolgsrezept: Schnell kopiert, ordentlich abgeheftet, innerlich abgehakt.

Bild: Kristian Laban, erstellt mit OpenAI GPT‑4o Image Generation

Eine dieser vermeintlich einfachen Fragen lautet erneut: Was steckt eigentlich dahinter, wenn ein Large Language Model (LLM) scheinbar mühelos mit mir kommuniziert?

Im Kern folgt das Large Language Model einer simplen Idee: der Vorhersage. Das LLM nimmt eine Abfolge von Wörtern und versucht, das wahrscheinlich nächste Wort zu erraten. Im Grunde ist das alles. Um darin gut zu werden, wird es mit gewaltigen Mengen an Text trainiert – oft mit nahezu allem, was öffentlich im Netz zugänglich ist.

Dabei merkt sich das Sprachmodell keine Inhalte. Es lernt Muster: Es lernt, was zusammengehört – Wortfolgen, Syntax, Kollokationen. Eine gängige Trainingsmethode ist das Maskieren: Wörter oder Satzteile werden ausgeblendet, und das Modell soll sie ergänzen. Ein Satz mit Lücke – das Modell rät, was fehlt. So entsteht nach und nach ein statistisches Gespür für sprachliche Strukturen – für das, was „passt“, was „stimmig klingt“.

Das Ergebnis: Texte, die sich überzeugend lesen lassen. Flüssig, anpassungsfähig, formbewusst. Der Output ähnelt dem, was ein Mensch in vergleichbarer Situation sagen könnte. Er klingt wie von Menschenhand – doch das heißt noch lange nicht: verstanden. Diese Systeme besitzen eine Art funktionales Sprachgefühl. Sie reagieren kontextsensibel. Sie variieren Tonfall, Stil, sogar Ironie. Doch sie tun dies ohne Bewusstsein, Absicht oder Erfahrung. Sie simulieren bestimmte Aspekte von Kommunikation – ohne jedoch deren Bedeutung im menschlichen Sinne zu erfassen.

Menschliches Denken, maschinelles Raten

Menschen denken in Zusammenhängen; sie verknüpfen, erinnern, erfinden. Menschen schließen aus wenigen Hinweisen auf größere Bedeutungen. Menschen abstrahieren aus Einzelfällen. Vor allem bilden Menschen Begriffe, die untrennbar mit Wahrnehmung, Emotion und Gedächtnis verbunden sind. Diese Art des flexiblen, leiblich verankerten Lernens bleibt den heutigen Modellen verschlossen.

Sprachmodelle verarbeiten Sprache – sprechen tun sie nicht. Begreifen schon gar nicht. Doch sie haben etwas Reales gelernt: wie Sprache funktioniert, wie sie verwendet wird, wie sie klingt. Sie liefern keine Gedanken, sondern Strukturen. Kein Wissen – aber Wahrscheinlichkeiten. Vielleicht genügt das auch – zumindest vorerst.

Die Mensch-Maschine: Wie ist dieser Beitrag entstanden?

Die Beiträge in dieser Rubrik entstehen in einem kreativen Dialog zwischen Mensch und Maschine. Die Einleitung des Textes wurde im Ping-Pong-Verfahren mit GPT gemeinsam formuliert. Der fachliche Teil basiert insbesondere auf zwei Podcasts: einem Interview mit Maria Liakata aus der Sendung Babbage von The Economist sowie einem Gespräch von Lex Fridman mit Sam Altman.

Die relevanten Passagen aus diesen Interviews wurden automatisiert transkribiert, bei Bedarf ins Deutsche übersetzt und mithilfe gezielter GPT-Prompts zu einem ersten Text verdichtet. Anschließend erfolgte ein menschliches Lektorat, bei dem ich gezielt Hinweise gab, an welchen Stellen die KI Argumentationslinien überprüfen, Kontexte ergänzen oder Übergänge glätten sollte, um den Beitrag in eine klare, stilistisch stimmige Form zu bringen.

Das Ziel dieses Prozesses ist es, den Weg vom ersten Gedanken bis zum fertigen Text so nahtlos und automatisiert wie möglich zu gestalten – zumindest der Idee nach.

Tags

Der Zufallsgenerator empfiehlt als nächsten Beitrag:

Monumentale Pilze, eine pulverisierende Perfomance und ein spontaner Handstand.